목록공부/Deep Learning (7)

dev-logs

보호되어 있는 글입니다.

7. CNN

7. CNN

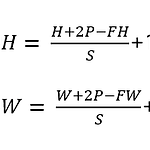

CNN 구조 - 합성곱 계층 convolutional layer 과 풀링 계층 pooling layer이 추가됨. - Conv계층, 활성화함수, Pool계층 순으로 이루어짐. 마지막 계층은 Affine, softmax 완전연결 계층의 문제점 - Affine 계층은 완전연결 계층이다. 계층의 뉴런이 모두 연결되고 출력의 수를 임의로 정할 수 있다. - 입력 데이터의 형상(차원)을 무시함. - CNN은 데이터의 형상을 유지함. 이미지도 3차원 데이터로 입력받고, 다음 계층에도 3차원 데이터로 전달함. - CNN 합성곱 계층의 입출력 데이터를 특징 맵 feature map 이라고 한다. 합성곱 연산 Convolution - CNN에서는 필터의 매개변수가 가중치에 해당한다. 편향도 존재할 수 있음. 편향은 항상..

매개변수 갱신 최적화: 손실 함수의 값을 가능한 낮추는 최적의 매개변수를 찾는 문제 확률적 경사 하강법 SGD 탐색 경로가 비효율적임. 그때그때 작은 범위의 기울기에 따라 경로가 결정되어서? 모멘텀 Momentum 속도 개념을 적용. AdaGrad 학습에서 중요한 요소인 학습률을 적응적으로 조정하면서 학습 진행. 과거의 기울기 제곱을 계속 더함. 매개변수의 원소 중 크게 갱신된 원소는 학습률이 낮아짐. 가중치의 초기값 가중치 값을 작게 하여 오버피팅 억제. 0.01 * np.random.randn(10,100) if 초기값을 0으로 하면? 순전파 때 모두 같은 값이 전파된다. 그러면 역전파때도 가중치가 똑같이 갱신됨 -> 의미 없는 행동 -> 초기값은 무작위로 설정하는게 좋음 (활성화값의 분포가 고르게 ..

오차역전파법 backpropagation 수치미분법으로 loss함수의 기울기를 구하는것은 쉽지만 오래 걸린다. 하지만 오차역전파법을 사용하면 빠르게 기울기를 구할 수 있다. 계산 그래프 computational graph 역전파법을 쉽게 이해할 수 있다. 전체 연산에서 연산 하나하나를 국소화한다. 전체 연산을 단순화할 수 있고 각 연산의 중간 결과값을 보관하기 쉽다. 연쇄법칙 chain rule 합성 함수의 미분에 대한 성질: 합성함수의 미분은 각 함수의 미분의 곱. 5장이 되게 중요한 챕터인것같은데 솔직히 완전히 이해는 못하겠다... 출처: 밑바닥부터 시작하는 딥러닝(한빛미디어)

3. 신경망 학습

3. 신경망 학습

학습 - 훈련 데이터로부터 가중치 매개변수의 최적값을 획득하는 것. - 손실 함수(Loss function)를 지표로 해서 loss함수의 결과값을 가장 작게 만드는 가중치 매개변수를 찾아야 한다. - 기울기 경사법 이용. - 훈련데이터 training data와 시험데이터 test data를 섞으면 안됨! - 어떤 데이터셋에 지나치게 최적화된 상태 overfitting 을 피하는 것 중요 특징 추출 - 컴퓨터 비전 분야에서는 SIFR, SURF, HOG 등이 있음. - 딥러닝인 특징 추출도 사람이 개입하지 않아도 됨. 손실함수 Loss function - 신경망 성능의 '나쁨'을 나타내는지표 -> 결과값이 작을수록 좋음. 결과값에 -1을 곱하면 '좋음'을 나타내게 됨. - 평균 제곱 오차, 교차 엔트로피..

Dateset MNIST (28x28 gray) 1. http://yann.lecun.com/exdb/mnist/ 에서 직접 다운받기 2. python 스크립트 사용 원-핫 인코딩 one-hot encoding - 결과중 정답을 뜻하는 원소만 1이고 나머지는 0인 배열 입력층 뉴런: 784개 출력층 뉴런: 10개 은닉층: 2개(50, 100) 이미지 픽셀값 정규화 예측 함수 1. MNIST 데이터셋을 읽고 네트워크 생성. 2. 이미지 그룹을 돌면서(for문) 분류함수 호출 3. 분류함수의 최대 출력값을 갖는 인덱스 구함. 데이터백색화 data whitening - 학습속도와 성능을 개선하기 위해서 데이터 전처리 과정을 거치게 된다. 데이터백색화는 전체 데이터를 균일하게 분포시키는 전처리 과정이다. - 연..

딥러닝 목적 분류와 회귀가 있다. - 분류 classification : 이미지 상의 객체를 종류(class)별로 구분하는 것. ex) 표지판, 자전거, 자동차, 행인 - 회귀 regression : 어떤 확률값을 예측하는 것. ex) 객체까지의 거리(M) 추정 활성화 함수 - 시그모이드 함수 sigmoid - 출력값의 분포를 부드럽게 바꿔주는 효과 (아날로그 신호처럼). - 0~1 사이의 출력값을 가진다. - 소프트맥스 함수 softmax - σ시그마로 표기 - 코드로 구현할때 오버플로 주의 (중간값들이 굉장히 크기 때문) - 상수(C)를 분자, 분모에 곱해서 오버플로 방지 (C=입력값중 최대값) - 출력값이 0~1 사이이고 모든 출력값의 합이 1이 되기 때문에 출력값을 확률로 해석할 수 있다. - 분..